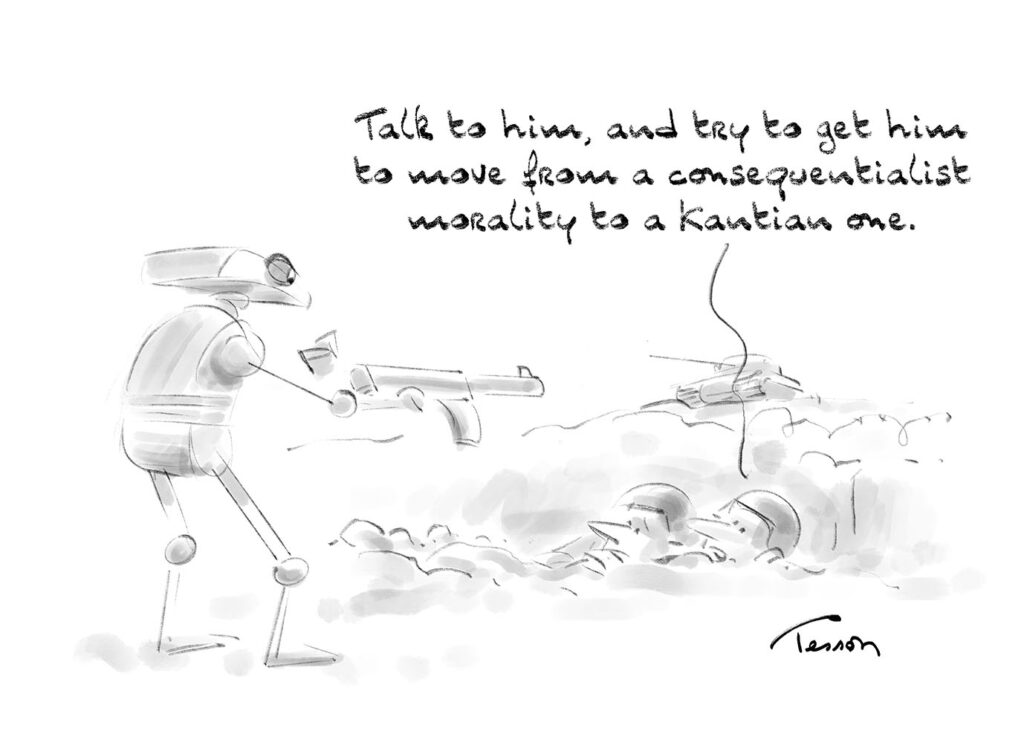

Pour programmer un robot militaire, faut-il privilégier la morale conséquentielle ou kantienne ?

1. La morale conséquentialiste (utilitariste)

Principe : on juge une action en fonction de ses conséquences.

Exemple pour un robot militaire : tirer seulement si cela maximise le « bien » (minimiser le nombre de morts, limiter les souffrances, protéger les civils).

Avantage : pragmatique, souple, « calculateur ».

Limite : un calcul coût/bénéfice peut justifier des actes terribles (ex. sacrifier un petit groupe d’innocents si cela sauve une majorité).

2. La morale kantienne (déontologique)

Principe : certaines actions sont moralement interdites, quelles qu’en soient les conséquences (ne pas tuer d’innocents, respecter la dignité humaine).

Exemple pour un robot militaire : ne jamais viser un civil, même si cela pouvait sauver davantage de vies par ailleurs.

Avantage : clarté, respect strict des droits humains, plus conforme au droit international humanitaire.

Limite : rigidité → le robot pourrait « échouer » dans des dilemmes tragiques (par exemple : un choix entre deux maux inévitables).

3. Que privilégier pour un robot militaire ?

En pratique, la communauté éthique et juridique tend à rejeter l’idée de déléguer à une machine des choix conséquentialistes complexes, car cela supposerait que l’IA « calcule » la valeur des vies humaines.

On privilégie plutôt une approche kantienne / déontologique, inscrite dans des règles claires et strictes (ne jamais cibler les civils, respecter les Conventions de Genève, etc.).

Cela correspond à ce qu’on appelle aujourd’hui le principe de “meaningful human control” : les décisions létales doivent rester sous responsabilité humaine, et les robots doivent être encadrés par des règles morales rigides.